کامپیوترها نحوه صحبت کردن ما را یاد میگیرند

اخیراً در کنفرانس جهانی توسعه دهندگان اپل، یکی از موارد اصلی و مهم، گنجاندن ویژگیهای اضافی برای تشخیص صدای هوشمند توسط “سیری” ( برنامه دستیار شخصی) در جدیدترین به روز رسانی سیستم عامل تلفن همراه iOS 9 بود.

اکنون، به جای اینکه از “سیری” بخواهید “فردا تولد کوین را به من یادآوری کن”، میتوانید به موقعیت و شرایط موجود تکیه کنید و فقط هنگام مشاهده پیغام رویداد فیس بوک برای تاریخ تولد، از سیری بخواهید “این را به من یادآوری کن”، چون “سیری” منظورتان را خواهد فهمید.

اکنون مدتی است فناوری مشابه این برنامه در ابزارهای گوگل وجود دارد و ما را هر چه بیشتر به تشخیص صدا از طریق آگاهی از زمینه صحبتمان نزدیک میکند.

در خصوص درک زمینه کلام، کامپیوترها در حال پیشرفت هستند، اما هنوز راهی طولانی را در پیش دارند!اما طرز کار همه اینها چگونه است؟ چرا زمینه صحبت آن قدر مهم است و چگونه با تشخیص صدا مرتبط است؟

برای پاسخ به این سؤال، لازم است که به نحوه عملکرد تشخیص صدا و ارتباط آن با حوزه مهم دیگر، یعنی پردازش زبان طبیعی نگاهی بیندازیم.

تاریخچهای مختصر از تشخیص صدا

آرزوی تحقق تشخیص صدا مدت زمانی طولانی است که در ناخود آگاه جمعی ما نهفته است. همیشه از خود پرسیدهایم که آیا بهتر نیست به جای ضربه زدن روی صفحه کلید، با کامپیوترمان به زبان طبیعی صحبت کنیم و او هر چیزی که میگوییم را درک کند؟

ما از زمان مکالمه “کاپیتان کرک” با کامپیوتر در کشتی “یو.اس.اس اینترپرایز” در سریال اصلی ” استار ترک” در دهه 1960 (و تلاش ناکام “اسکاتی” برای گفتگو با کامپیوتر قرن بیستمیاش در یکی از فیلمهای بعدی این سریال) در رؤیای تحقق آن بودهایم.

حتی فیلمهای ساخته شده در سالهای اخیر ایده تشخیص صدای پیشرفته را دست مایه خود قرار دادهاند. مثلاً در فیلم “اسنیکرز” (محصول 1992) با موضوع فناوری، “رابرت ردفورد” با درد سر بخشهایی از صدای یک مدیر را جمع آوری میکند و آنها را با استفاده از یک ضبط صوت در کامپیوتر پخش میکند تا به سیستم قابلیت پخش صوت بدهد.

تصویر سادهای که از این فناوری در فیلمهای علمی- تخیلی ترسیم میشود، پیچیدگی پروسه واقعی آن را دور از دید نگه میدارد. قبل از این که کامپیوتر حتی متوجه منظورتان شود، باید بتواند کلمات شما را بفهمد.

این کار نیازمند یک فرآیند پیچیده است که شامل نمونه گیری صوتی، استخراج ویژگی و بعد تشخیص گفتگوی واقعی برای شناسایی صداهای منفرد و تبدیل آنها به متن است.

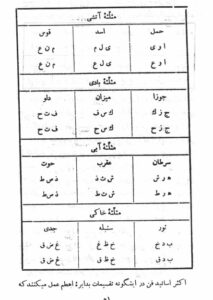

محققان سال هاست که روی این فناوری کار میکنند. آنها تکنیکهایی را به دست آوردهاند که کامپیوترها با استفاده از آنها قادرند ویژگیهای صدا را با روشی مشابه گوش انسان استخراج کنند و آنها را به عنوان آواها و صداهایی که انسان به عنوان بخشی از کلام تولید میکند، تشخیص دهند. این کار شامل استفاده از شبکههای عصبی مصنوعی، مدلهای پنهان “مارکوف” و سایر ایدههایی است که همه بخشی از حوزه وسیع هوش مصنوعی هستند.

از طریق این مدلها میزان تشخیص گفتار توسط کامپیوترها بهبود یافته است. در سال جاری گوگل نرخ خطاهای تشخیص گفتار را کمتر از 8٪ گزارش داده است.

اما حتی با وجود این پیشرفتها، تشخیص صدا تنها نیمی از این چالش است. وقتی کامپیوتر این پروسه را با موفقیت طی کند، فقط متنی را ارائه میدهد که تکرار گفتههای شماست. این در حالی است که شما میتوانستید هر چیزی را بگویید.

سیستمهای جدیدتر از الگوریتمهای یاد گیری ماشین شبیه مدلهای پنهان “مارکوف” که در تشخیص گفتار استفاده میشود، برای ساخت واژگان استفاده میکنند.مرحله بعدی، پردازش زبان طبیعی است.

اصل مطلب را گرفتید؟

هنگامی که کامپیوتر کلام شما را به متن تبدیل کرد، در مرحله بعد باید چیزهایی که گفتهاید را واقعاً درک کند. این فرآیند “پردازش زبان طبیعی” نامیده میشود. مسلماً این مرحله دشوارتر از پروسه تشخیص صدا است، زیرا زبان انسان پر از مفهوم و معنا است که پروسه تشخیص زبان طبیعی را دشوار میکند.

هر کسی که از سیستمهای قبلی تشخیص صدا استفاده کرده است، دشوار بودن این پروسه را تأیید میکند. دایره لغات سیستمهای اولیه بسیار محدود بود و شما میبایست دستورات را دقیقاً به روش صحیح میگفتید تا اطمینان حاصل کنید که کامپیوتر آنها را درک میکند.

این امر نه تنها در مورد سیستمهای تشخیص صدا، بلکه حتی در سیستمهای پردازش متنی که ترتیب کلمات و درج کلمات خاص تفاوت زیادی در نحوه پردازش سیستم ایجاد میکرد نیز صادق بود. زیرا سیستمهای اولیه پردازش زبان از قوانین سخت و درخت تصمیم برای تفسیر دستورات استفاده میکردند، بنابراین هر گونه خطا و سرپیچی از این دستورات مشکلاتی را ایجاد میکرد.

با این وجود سیستمهای جدیدتر از الگوریتمهای یاد گیری ماشین شبیه مدلهای پنهان “مارکوف” که در تشخیص گفتار استفاده میشود، برای ساخت واژگان استفاده میکنند. این سیستمها هنوز هم نیاز به آموزش دارند، اما میتوانند براساس وزن دهی هر کلمهای که استفاده میشود، تصمیمات “نرمتری” بگیرند. به این ترتیب امکان پرس و جوهای قابل تغییر فراهم میشود، به طوری که زبان مورد استفاده میتواند تغییر کند اما محتوای پرس و جو میتواند ثابت بماند.

به همین دلیل است که میتوانید از “سیری” بخواهید که ” یک تاریخ برای نوبت خشک شویی در ساعت 9 صبح تنظیم کن” یا ” در تقویم من روز نوبت خشک شویی در ساعت 9 صبح را وارد کن” و یک نتیجه یکسان به دست آورید.

اما چگونه با صداهای مختلف کنار میآیید؟

با وجود این پیشرفتها، هنوز چالشهایی در این زمینه وجود دارد. تشخیص صدا، لهجهها و تلفظ هنوز هم میتواند مشکلاتی ایجاد کند.

به دلیل نحوه عملکرد سیستمها، تلفظ متفاوت آواها باعث میشود سیستم آن چه شما گفتهاید را تشخیص ندهد. این امر به ویژه هنگامی صادق است که به نظر میرسد آواها در یک کلمه (به نظر افراد غیر محلی) هیچ ارتباطی با نحوه تلفظ ندارند، مانند شهرهای “لستر” یا “گلاسگو” در انگلیس.

هنگامی که کامپیوتر کلام شما را به متن تبدیل کرد، در مرحله بعد باید چیزهایی که گفتهاید را واقعاً درک کند. این فرآیند “پردازش زبان طبیعی” نامیده میشود.به نظر میرسد حتی تلفظ شهرهای استرالیا مانند “ملبورن” برخی از آمریکاییها را دچار مشکل میکند. در حالی که از نظر یک استرالیایی تلفظ “ملبورن” بسیار واضح است، روش متفاوت استفاده از آواها در آمریکا باعث میشود استرالیاییها اغلب تلفظ آمریکایی “ملبورن” را اشتباه بشنوند. (البته گوشهای ناآشنا).

هر کسی که از سیستم جی.پی.اس تلفظ اشتباه “ایپسویچ” را به عنوان “ایپ-سویچ” شنیده باشد، میداند این مسئله دو جانبه و متقابل است. تنها راه حل آن، آموزش روشهای مختلف تلفظ کلمات به سیستم است. اما با تغییر در لهجهها (و حتی تغییر تلفظ در لهجهها) این آموزش میتواند به فرآیند کاملاً پیچیده و گستردهای تبدیل شود.

از جنبه پردازش زبان، این موضوع عمدتاً از نوع زمینه و موقعیت است. مثالی که در ابتدای مقاله آوردیم نمونهای از وضعیت هنر در پردازش زبان وابسته به زمینه را بیان میکند. اما تمام کاری که شما باید انجام دهید این است که به یک مکالمه چند دقیقهای توجه کنید تا متوجه شوید که چقدر نحوه صحبت خود را تغییر میدهید و به کامپیوتر زمینه و مفهوم بیشتری منتقل میکنید.

به عنوان مثال، چند بار از شخصی میپرسید:

ایمیل من را دریافت کردی؟

اما منظورتان در واقع این است:

ایمیل من را دریافت کردی؟ اگر دریافت کردی، آن را خواندهای؟ لطفاً به این سؤال پاسخ میدهی؟

اوضاع از این هم پیچیدهتر میشود وقتی میخواهید با یک کامپیوتر مکالمه کنید و سؤال اول و سؤالات بعدی را بپرسید، مانند “شماره مارتین چیست؟”، “با او تماس بگیر” یا “برای او پیام کوتاه بفرست”.

در خصوص درک زمینه کلام، کامپیوترها در حال پیشرفت هستند، اما هنوز راهی طولانی را در پیش دارند!

میزان تشخیص گفتار توسط کامپیوترها بهبود یافته است.

ترجمه خودکار

ما در بسیاری از زمینههای مختلف پیشرفت زیادی کردهایم تا به این مرحله برسیم. اما هنوز چالشهایی در تشخیص لهجه، مفاهیم ضمنی در زبان و زمینه در مکالمات پیش رویمان است. این بدان معناست که ممکن است مدتی طول بکشد تا ما کامپیوترهای “استار ترک”را برای تفسیر گفتگوهای خود داشته باشیم.

اما خیالتان راحت باشد، ما به آرامی در حال نزدیک شدن به این هدف هستیم. پیشرفتهای اخیر مایکروسافت در ترجمه خودکار نشان میدهد که اگر آن را درست انجام دهیم، دستاورد نهایی آن میتواند بسیار جالب و هیجان انگیز باشد.

گوگل اخیراً از یک فناوری جدید پرده برداری کرده است که از ترکیبی از تشخیص صدا یا تصویر، پردازش زبان طبیعی و دوربین تلفن هوشمند شما برای ترجمه خودکار علائم و مکالمات کوتاه از یک زبان به زبان دیگر استفاده میکند. حتی سعی میکند فونتها را مطابقت دهد تا علائم یکسان باشد، البته به زبان انگلیسی!

بنابراین دیگر نیازی نیست که برای سر در آوردن از یک منو به زبان ایتالیایی تلاش کنید یا برای این که به پیشخدمتی که انگلیسی صحبت نمیکند، سفارش دهید، احساس درماندگی کنید. گوگل مشکل شما را حل کرده است، البته نه به اندازه “یو.اس.اس انترپرایز”، اما بهتر از قبل!

آیا بهتر نیست به جای ضربه زدن روی صفحه کلید، با کامپیوترمان به زبان طبیعی صحبت کنیم و او هر چیزی که میگوییم را درک کند؟

منبع: مایکل کاولینگ، CQUniversity Australia

ترندنیوز مطالب مذهبی+آموزشی+سرگرمی+خبری

ترندنیوز مطالب مذهبی+آموزشی+سرگرمی+خبری